L’ intelligenza artificiale è sempre più presente nella vita di tutti: dai chatbot, che tra le altre cose stanno progressivamente sostituendo i motori di ricerca su internet, agli strumenti che sempre più spesso utilizziamo per scrivere testi, analizzare dati o creare immagini. Assieme alle opportunità crescono però anche le inquietudini: oltre duecento scienziati, politici e premi Nobel durante l’ultima assemblea generale dell’Onu hanno presentato un appello per imporre limiti etici e normativi allo sviluppo delle Ia, denunciando rischio di “perdere il controllo” sulle macchine. Sullo sfondo rimane la domanda cruciale: quanto potranno diventare realmente autonome queste tecnologie? Riusciranno un giorno a sviluppare addirittura una propria coscienza?

Questioni come queste sono state il filo conduttore della serata tenutasi lo scorso 26 settembre presso l’agrobar Campo dei Girasoli, a Padova in via Bainsizza 31, dove il Dipartimento di ingegneria dell’informazione dell’Università ha organizzato uno degli appuntamenti del ciclo [Ing.tonic], dedicato a esplorare i confini tra tecnologia e società. Davanti a un pubblico attento e curioso Ruggero Carli e Pietro Falco, entrambi docenti di robotica presso l’ateneo padovano, hanno intrecciato fantascienza, ingegneria, filosofia ed etica per affrontare una delle domande più radicali del nostro tempo: cosa significa “intelligenza” in una macchina, e cosa invece resta specificamente umano.

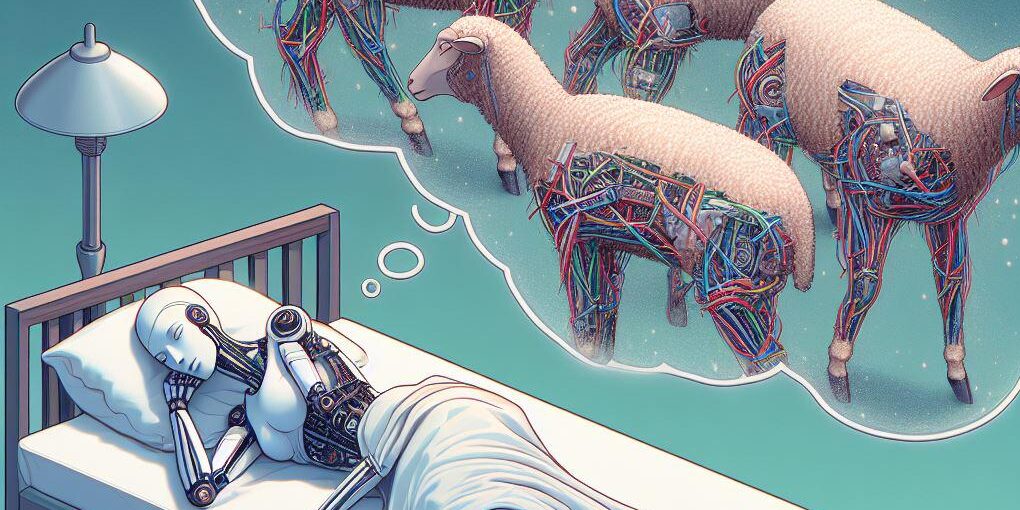

L’incontro ha preso le mosse dalla provocazione di un grande scrittore di fantascienza come Philip K. Dick, che in un libro (dal quale è stato tratto il film Blade Runner) si chiede ironicamente se gli androidi sognino pecore elettriche: «In fondo tante cose che un tempo ci sembravano impossibili oggi sono realtà: da bambini guardavamo Supercar e oggi abbiamo le auto a guida autonoma – spiega alla Difesa Ruggero Carli – È quindi lecito chiedersi se un giorno potremmo avere robot capaci di provare emozioni. Per il momento i robot parlano ma non sanno cosa dicono, non hanno coscienza e ovviamente non sognano».

Carli ripercorre l’evoluzione della robotica e dell’intelligenza artificiale: dai primi bracci meccanici nelle catene di montaggio ai sistemi che oggi vengono addestrati a muoversi e ad apprendere nell’ambiente. Le reti neurali artificiali, spiega Carli, nascono dall’idea di emulare alcuni meccanismi di apprendimento del cervello: «Come accade a un bambino che, osservando, costruisce correlazioni e generalizzazioni. Il cuore delle nostre ricerche è capire come mettere i robot nelle condizioni di imparare da soli, senza dire loro passo dopo passo cosa fare, in modo da compiere azioni sempre più complesse in ambienti lavorativi difficili, pericolosi o faticosi per l’essere umano, come per esempio quelli post-catastrofe».

Rimane la questione di definire l’intelligenza e, soprattutto, la coscienza. «Un computer, per sua natura, può solo fare calcoli – sottolinea Pietro Falco – Non è un’intelligenza come la intendiamo noi esseri umani». Falco richiama il famoso esperimento mentale della “Stanza cinese” di John Searle per chiarire la distanza tra utilizzare dei simboli e comprenderne il significato: «Se chiedo a un sistema cosa fare quando fa freddo può rispondere “metti la giacca”, ma non sa cos’è il freddo né cos’è una giacca. Non avendo coscienza, non ha esperienza soggettiva. Padroneggia la sintassi ma non la semantica». Per un osservatore umano, il comportamento può dare l’impressione che la macchina “capisca”, ma si tratta pur sempre di una nostra proiezione mentale.

Resta tuttavia aperto il tema, enorme, di cosa sia la coscienza: «Molti scienziati oggi cercano di spiegarla con concetti – osserva Falco – La coscienza è però innanzitutto qualcosa che si vive in prima persona, al di là di definizioni astratte. I concetti si formano nella coscienza, non il contrario». Un aiuto negli ultimi anni viene dai contemplative studies, che intrecciano neuroscienze e tradizioni contemplative orientali e occidentali per indagare in modo diretto l’esperienza cosciente. Il dibattito è aperto: «Alcune correnti filosofiche sostengono che la coscienza emerga dalla materia, altre mettono in discussione questa premessa. In ogni caso, al momento non esistono strumenti ingegneristici per generare una coscienza artificiale».

Sul piano tecnologico ed etico, però, la questione è urgente. Per la prima volta l’umanità ha creato agenti artificiali capaci di apprendere, prendere decisioni e agire nel mondo. Ma chi è responsabile delle loro azioni? Falco ricorda che «la responsabilità rimane umana: siamo noi a dover coltivare saggezza ed etica per decidere cosa amplificare, il bene o il male. La tecnologia è neutrale: non sa cos’è giusto o sbagliato». Anche Carli insiste sul punto: la sfida non è solo tecnica ma soprattutto culturale e politica.

Se dunque i robot non sognano (ancora) rimane interamente a nostro carico il compito di costruire una società più libera e giusta. Il futuro dell’intelligenza artificiale non dipenderà solo dalla potenza delle macchine, ma dalla capacità degli esseri umani di restare vigili, coltivando la consapevolezza e governando con responsabilità. La tecnologia non basta: serve un’umanissima saggezza, unita a buonsenso.

Mercoledì 29 ottobre, incontro sull’IA generativa

L’ultimo appuntamento di [Ing.tonic] promosso da Dipartimento di ingegneria dell’informazione è per mercoledì 29 ottobre alle 19 al locale Amsterdam. Si parlerà di “IA Art attack: contenuti leciti e illeciti dell’Intelligenza artificiale generativa”.